Introduzione

L’Intelligenza Artificiale (IA) è oggi uno dei temi più discussi in ogni ambito. Quello che vedo però è che spesso si da per scontato che le persone (tutte le persone) capiscano al volo di cosa si sta parlando, le sigle, dei nomi, le terminologie tecniche, i contesti.

Per mia esperienza, non do mai nulla per scontato, soprattutto quando stiamo parlando di un qualcosa che è relativamente nuovo e che, soprattutto, si evolve in maniera estremante veloce. Di un qualcosa che è ancora nebuloso per molti, e non per ignoranza ma semplicemente per mancanza di tempo o di occasioni per approfondire.

Basti pensare alle decine di novità che sono uscite negli ultimi mesi per rendersene conto nel mondo dei modelli di IA, tra nuove piattaforme per immagini, video o modelli più piccoli con altissime prestazioni.

La domanda che mi sono fatto è come uno stampatore o un creativo può star dietro a tutto questo, soprattutto se siamo ogni giorno focalizzati sulla creazione di progetti grafici, sulla qualità e la resa dei colori, sulla configurazione delle stampanti e la qualità del risultato finale. Insomma, su ciò che ci fa crescere professionalmente e personalmente.

Però, l’IA oltre a essere un tumultuoso presente, è anche il prossimo futuro. È qui per restare e noi dobbiamo essere in grado di contestualizzare tutte le novità che arriveranno, sia come piattaforme separate sia se inserite nei nostri software grafici o di gestione progetti o clienti. Ci servirà altresì per capire eventuali proposte da fornitori e consulenti circa l’uso dei nostri dati per applicazioni di business che utilizzano l’IA.

Per questo ho preparato questo articolo che illustra, in maniera molto semplificata, ciò che ci serve sapere sull’IA e i suoi componenti, come si relazionano tra di loro e che connessioni hanno.

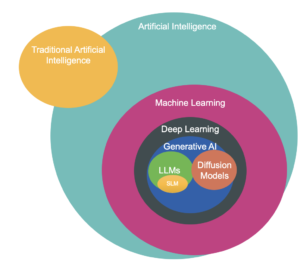

Se pensiamo all’IA, possiamo raffigurarla come una serie di sotto insiemi. L’IA infatti racchiude al suo interno discipline sempre più specifiche. Sfrutteremo questo esempio consci anche del fatto che semplificheremo alcuni concetti che però ognuno di noi può sempre approfondire personalmente.

Intelligenza Artificiale (IA)

Partiamo dall’inizio, cioè dal concetto di Intelligenza Artificiale. L’IA, come probabilmente abbiamo già intuito, è una disciplina dell’informatica che si occupa di creare sistemi in grado di simulare comportamenti umani, come prendere decisioni, suggerire soluzioni, riconoscere immagini o comprendere il linguaggio naturale. Lo scopo dell’IA è rendere le macchine capaci di eseguire compiti che normalmente richiederebbero l’intelligenza umana. L’IA è un grosso ombrello, che copre diverse altre cose, oppure, se volete, immaginatelo come la fisica classica che studiamo a scuola, che racchiude altre materie come la termodinamica, il magnetismo o la meccanica.

Differenza tra IA tradizionale e Machine Learning

Prima di esplorare il Machine Learning, che è il primo step all’interno dell’IA, è importante comprendere la differenza tra i sistemi tradizionali di IA che si utilizzavano in maniera pressochè unica prima dell’arrivo dell’IA generativa e quelli basati sul Machine Learning, cioè sistemi che imparano da soli.

Nei sistemi di IA tradizionali, detti anche condizionali, si utilizzano regole apunto condizionali ‘if-then’ (se accade questo, allora fai questo) dove ogni possibile scenario è pre-programmato da un esperto (infatti sono chiamati anche sistemi esperti). Questo approccio, che sfrutta la conoscenza e l’esperienza in un determinato campo (chiamato anche knowledge base) e fornisce soluzioni in base a una serie di risposte sequenziali. Sono sistemi che sono stati usati ad esempio nella diagnostica medica o in configuratori per la scelta di un prodotto o in procedure di manutenzione e identificazione guasti.

Il problema di questi sistemi è che per adattarsi a nuovi scenari necessitano ogni volta di essere rivisti e riprogrammati e per situazioni complesse con molte variabili, questo rappresenta un limite, date le risorse che tali attività necessitano senza comunque acquisire flessibilità. Da qui la necessità di trovare alternative più efficaci e che autonomamente possano gestire situazioni nuove o inaspettate.

Abbiamo citato l’IA tradizionale perché, pur se in maniera minore che in passato, i modelli condizionali si usano dove la quantità di dati non è alta, dove complessità è gestibile o dove vi sono limiti di costo sui progetti.

Machine Learning (ML)

All’interno dell’ombrello che rappresenta l’IA troviamo il Machine Learning. Il ML è una sotto-disciplina dell’IA che si focalizza su algoritmi e modelli che permettono alle macchine di ‘imparare’ dai dati. In altre parole, anziché programmare esplicitamente ogni passo, i sistemi di ML identificano schemi e fanno previsioni o decisioni basate su dati passati. Un esempio di questo funzionamento è una app di musica che suggerisce nuove canzoni basate sugli ascolti precedenti oppure previsioni del traffico basate sullo storico dei dati precedenti. Qui si stanno utilizzando tecniche di Machine Learning. Il ML è stato una rivoluzione nel suo ambito, soprattutto con l’adozione di reti neurali sempre più sofisticate, che ha segmentato ancor di più le applicazioni possibili come vedremo sotto.

Deep Learning (DL)

All’interno del Machine Learning, troviamo il Deep Learning, una verticalizzazione delle applicazioni di Machine Learning appunto. Il Deep Learning utilizza reti neurali artificiali molto sofisticate con diversi strati (da qui il nome Deep) strutture ispirate al cervello umano e rese tramite modelli matematici, per analizzare grandi quantità di dati e fare previsioni molto precise.

È il DL che, insieme ai dati disponibili e alla discesa dei costi di computazione dei dati stessi, ha reso possibili molte delle recenti innovazioni nell’IA, come il riconoscimento delle immagini o la comprensione del linguaggio naturale. Quando si carica una foto su un social network e il sistema riconosce automaticamente i volti nelle immagini, c’è il Deep Learning in azione.

AI Generativa

Un sottoinsieme del Deep Learning che ha guadagnato una grandissima popolarità è l’IA Generativa. Questa sotto branca dell’IA utilizza modelli di Deep Learning per creare nuovi contenuti, come immagini, testo, audio, video o codice, a partire da dati esistenti. L’AI Generativa non si limita a fare previsioni, ma è in grado di generare qualcosa di completamente nuovo in base ai comandi dell’utente, spesso forniti sotto forma di ‘prompt’ in linguaggio naturale. È nell’IA generativa che troviamo la maggior parte delel applicazioni che oggi sono così popolari, da ChatGPT a MidJourney, da Claude a Dall-E o Sora. I campi specifici in cui lavora includono:

– Generazione di testo – Creazione di articoli, storie o risposte a domande (es. ChatGPT o Gemini).

– Generazione di immagini – Creazione di immagini originali (appunto MidJourney, Leonardo, Dall-E, Adobe Firefly)

– Generazione di audio – Creazione di tracce musicali o sintesi vocale (es. Suno o Udio).

– Generazione di video – Creazione di brevi clip video a partire da descrizioni testuali (es. Sora, Runaway, HeyGen).

– Generazione di codice -Scrittura di codice sorgente in vari linguaggi di programmazione.

L’IA generativa utilizza architetture neurali molto sofisticate, come i Transformer, che si basano su diversi layer di software e che utilizzano migliaia di parametri al loro interno per fornire i risultati attesi.

La tendenza oggi è quella di avere modelli con milioni di parametri perché più alto è il numero, migliore è la resa e la performance del modello (a seconda di quello che si vuole fare ovviamente). Questi modelli sono addestrati su enormi quantità di dati in modo che possano poi identificare e ricreare pattern senza l’intervento umano, e si può dialogare con loro tramite prompt, ovverossia richieste in linguaggio naturale, come abbiamo visto nel precedente articolo.

È importante ricordare che, sebbene l’IA offra strumenti molto potenti, il ruolo della creatività umana e l’indirizzamento delle scelte creative in base alle esigenze del cliente rimane centrale e insostituibile. L’IA è un potenziatore di capacità creative e produttive, e non un mero sostituto della professionalità umana, che anzi, può sperimentare di più e meglio, in maniera veloce e a costi abbordabili.

LLM – Modelli di linguaggio di grandi dimensioni

Abbiamo visto che l’IA generativa è divisa per applicazioni. Quella del testo è basata su LLM ovvero ai Modelli di Linguaggio di Grandi Dimensioni, un tipo specifico di AI Generativa, dedicato principalmente alla gestione e processo del testo. Gli LLM, come GPT-4, sono modelli addestrati su enormi quantità di testo per comprendere e generare linguaggio naturale in modo fluente. Questi modelli possono scrivere articoli, rispondere a domande tradurre testi, post per social, idee per brainstorming, strategie marketing e di vendita e molto altro.

Gli LLM più famosi sono ChatGPT di OpenAI, Gemini di Google, Claude di Antrophic, Mistral, Perplexity, GroK di X, Copilot di Microsoft. Da tener presente che questi modelli oggi sono addestrati e possono lavorare non solo con il testo ma anche con immagini e codici di programmazione (nonché vari tipi di file come PDF Excel ecc.). Per questo sono detti multimodali oppure omnimodali. Ad esempio, ChatGPT include al suo interno Dall-E per la generazione di immagini.

Oggi però sta prendendo piede anche la possibilità di avere sistemi basati e addestrati sui propri dati, che non sono condivisi all’esterno ma sono proprietà dell’azienda. In questo caso parliamo di SLM o modelli di linguaggio più piccoli (Small Language Model), in cui girano principalmente dati aziendali, che possono venire dal CRM, dal CMS, dal nostro ERP aziendale o knowledge base su SharePoint o semplici file di uso interno (ad esempio file di prodotto o di servizi offerti). Questi modelli, pur essendo meno potenti dei LLM in termini di parametri, sono altamente efficienti e possono essere utilizzati in applicazioni dove le risorse computazionali sono limitate o non si vuole affidare i propri dati ad altri. Gli SLM stanno vedendo una grande crescita grazie alla loro capacità di essere implementati su dispositivi meno potenti e di fornire comunque prestazioni eccellenti in compiti specifici.

Un’altra cosa da sapere sugli LLM e SLM. Esistono modelli Open Source, cioè scaricabili e programmabili dagli utenti, come ad esempio Llama di Meta, e che crescono in base all’esperienza e alla condivisone degli utenti. Vi sono poi modelli Closed Source, come ChatGPT o Gemini che sono appunto chiusi dall’azienda che ne controlla il codice e l’addestramento.

Un esempio comune dell’uso di LLM è un chatbot avanzato che può lavorare su un database creato e gestito dall’azienda in modo da controllare le risposte e che può essere basato su tecnologia open o closed source.

DM – I modelli di diffusione

I modelli di diffusione (o diffusion model) sono architetture che servono per la riproduzione delle immagini, video ma anche audio. Sono estremamente importanti per chi fa grafica o creatività perché la maggior parte dei software di IA generativa per immagini utilizza questo modello. La creazione delle immagini avviene tramite una richiesta fatta in linguaggio naturale (prompt), proprio come negli LLM, su cui basano molte soluzioni in comune.

Il software, tramite delle operazioni particolari (chiamate diffusion e denoising), genera l’immagine richiesta. Si possono aggiungere parametri per riproduzioni particolari (es, tipo di macchina fotografica o focale) o lavorare su dettagli dell’immagine. Stable Diffusion, MidJourney, Imagen o Adobe Firefly sono tutti software che usano i modelli di diffusione per la creazione d’immagini. Da ricordare che questi modelli sono ormai fondamentali per chiunque lavori nel campo della grafica o della stampa digitale, offrendo nuovi strumenti per esplorare e innovare soluzioni grafiche, creare mock-up e prototipi di applicazioni grafiche (ad esempio proposte di packaging o ambientazioni di grafiche da interno) e presentazioni accattivanti per la clientela in poco tempo.

Conclusione

L’Intelligenza Artificiale è un campo vasto e complesso, ma non per questo oscuor. Basta solo sapere che è composta da livelli che racchiudono concetti sempre più specifici e potenti, cime abbiamo visto sopra. Dall’IA generale fino agli LLM, ognuno di questi concetti gioca un ruolo fondamentale nel rendere le tecnologie moderne più intelligenti e capaci di aiutarci nei nostri compiti quotidiani.

All’atto di un progetto, di considerazioni d’acquisto di sistemi o dell’uso di determinate applicazioni, capire come esse si situano nel contesto dell’IA può essere senz’altro d’aiuto e dissipare confusione o dubbi o a discutere in maniera più consapevole con eventuali fornitori.

Come abbiamo detto, ogni specifico argomento può essere approfondito ma, come per guidare la macchina non dobbiamo essere necessariamente meccanici esperti, così per utilizzare l’IA i fondamentali possono essere già abbastanza per muoversi agevolmente tra terminologie e applicazioni.

Glossario

Intelligenza Artificiale (IA):

Una disciplina dell’informatica che si occupa di creare sistemi in grado di simulare comportamenti umani, come prendere decisioni, riconoscere immagini o comprendere il linguaggio naturale.

Machine Learning (ML):

Una sotto-disciplina dell’IA che si focalizza su algoritmi e modelli che permettono alle macchine di “imparare” dai dati. Piuttosto che essere programmati per ogni possibile scenario, i sistemi di ML identificano schemi e fanno previsioni basate su dati passati.

Deep Learning (DL):

Una specializzazione del Machine Learning che utilizza reti neurali artificiali molto sofisticate, ispirate al cervello umano, per analizzare grandi quantità di dati e fare previsioni molto precise. È alla base di molte delle recenti innovazioni nell’IA.

AI Generativa:

Una branca dell’IA che utilizza modelli di Deep Learning per creare nuovi contenuti, come immagini, testo, audio, video o codice, a partire da dati esistenti. Gli utenti interagiscono con questi sistemi utilizzando “prompt” in linguaggio naturale.

Modelli di Linguaggio di Grandi Dimensioni (LLM):

Modelli IA specializzati nella gestione e generazione di linguaggio naturale. Questi modelli, come GPT-4, sono addestrati su enormi quantità di testo e possono svolgere una varietà di compiti, dalla scrittura di articoli alla traduzione di testi.

Modelli di Linguaggio di Piccole Dimensioni (SLM):

Versioni più leggere e focalizzate dei LLM, che possono essere addestrate su dati specifici di un’azienda o su risorse limitate. Sono utili quando si desidera mantenere il controllo sui propri dati o quando le risorse computazionali sono limitate.

Modelli di Diffusione (Diffusion Models):

Architetture utilizzate principalmente per la generazione di immagini, video, e audio. Questi modelli funzionano tramite un processo di “diffusion” e “denoising” per creare contenuti visivi e sonori di alta qualità a partire da descrizioni testuali o altre informazioni di input.